2025. 2. 23. 22:55ㆍ컴퓨터비전&AI

DUSt3R: 기하학적 3D 비전의 간편한 적용

주어진 제약 없는 이미지 모음(즉, 카메라 자세 및 내부 매개변수가 알려지지 않은 사진 세트)을 입력으로 사용하면, 제안된 DUSt3R 방법은 상응하는 포인트맵(촘촘한 2D→3D 매핑)을 출력합니다.

이를 통해 한 번에 추정하기 어려운 다양한 기하학적 요소를 쉽게 복원할 수 있습니다.

복원 가능한 기하학적 요소

- 카메라 보정(Camera calibration): 초점거리, 회전행렬, 이동벡터 등등

- 깊이 추정(Depth estimation)

- 픽셀 간 대응(Pixel correspondences): 서로 다른 이미지에서 같은 3D 점을 나타내는 픽셀을 찾아 연결하는 과정

- 카메라 자세 추정(Camera pose estimation)

- 밀집 3D 재구성(Dense 3D reconstruction)

이 방법은 단일 이미지(monocular reconstruction)에서도 작동하여,

한 장의 사진만으로도 3D 복원을 수행할 수 있습니다.

DUSt3R은 카메라 매개변수를 모르는 경우에도 다음 데이터셋에서 높은 품질의 결과를 제공합니다.

- DTU Dataset

- Tanks and Temples Dataset

- ETH-3D Dataset

각 샘플에서 왼쪽부터 순서대로:

1️⃣ 입력 이미지

2️⃣ 컬러 포인트 클라우드(Colored Point Cloud)

3️⃣ 음영 적용된 렌더링(Shaded Render) – 기하학적 구조를 더 잘 보여줌

[ Abstract ]

핵심 개념: 포인트맵 회귀(Pointmap Regression)

우리는 기존의 투영 카메라 모델(projective camera model)의 제약을 완화하고, 포인트맵 회귀(pointmap regression)로 쌍(pairwise) 재구성 문제를 해결합니다.

이 접근 방식은 단안(monocular) 및 쌍안(binocular) 재구성을 자연스럽게 통합할 수 있도록 합니다.

다중 이미지(Global Alignment)

- 두 장 이상의 이미지가 주어지는 경우, 우리는 모든 포인트맵을 공통 참조 프레임(common reference frame)에서 정렬하는 단순하지만 효과적인 글로벌 정렬(global alignment) 전략을 제안합니다.

네트워크 구조 & 학습 방식

- DUSt3R는 표준 Transformer 인코더-디코더 아키텍처를 기반으로 하여,

사전 학습된 강력한 모델(pretrained models)의 활용이 가능합니다.

결과: 3D 모델 & 다양한 비전 작업의 통합

- DUSt3R는 장면(scene)의 3D 모델 및 깊이 정보(depth information)를 직접 복원할 수 있습니다.

- 뿐만 아니라, 픽셀 매칭(pixel matches), 상대/절대 카메라 자세(relative & absolute camera poses)도 손쉽게 추출할 수 있습니다.

실험 결과 & 성능 평가

다양한 실험을 통해 DUSt3R가 여러 3D 비전 작업을 단일 프레임워크에서 통합할 수 있으며,

특히 단안/다중 뷰 깊이 추정(monocular/multi-view depth estimation)과 상대 자세 추정(relative pose estimation)에서 새로운 SOTA(State-of-the-Art) 성능을 기록했음을 보여줍니다.

[ Conclusion ]

DUSt3R는 여러 기하학적 3D 비전 작업을 보다 쉽게 수행할 수 있도록 하며,

단순하지만 강력한 방법으로 다양한 3D 비전 문제를 해결하는 새로운 패러다임을 제시합니다.

전통적인 수작업 기법들(a)은, 해당 도메인에 맞춰 학습된 학습 기반 접근 방식들(b)에 의해 이미 뛰어넘어진 상태다.

- 성능(정확도) 지표만 놓고 보면, GT 정보를 사용하는 방법들보다 조금 짐.

- GT 없이도 3D 재구성과 다양한 비전 작업을 수행할 수 있다

그림 4. 보이지 않은 MegaDepth 장면을 단 두 장의 이미지(왼쪽 위)로부터 3D 재구성한 예시.

이는 네트워크의 원시 출력(raw output) 결과로,

- 위쪽 중앙에는 출력 깊이맵(식 (8) 참고),

- 오른쪽 위에는 신뢰도(confidence) 맵,

- 중간과 아래에는 컬러 포인트 클라우드를 두 가지 다른 시점에서 시각화한 모습을 보여준다.

카메라 파라미터는 원시 포인트맵으로부터 복원되며, 자세한 내용은 본문 3.3절을 참고.

DUSt3R는 시점과 초점 길이가 크게 변하는 상황도 별다른 문제 없이 처리 가능하다.

Figure 5. 두 장의 이미지만을 이용한 이전에 보지 못한 MegaDepth [56] 장면의 3D 재구성 예제.

이것은 네트워크의 가공되지 않은(raw) 출력으로,

- 출력된 깊이 맵(depth maps, 상단 중앙)

- 신뢰도 맵(confidence maps, 상단 오른쪽): 특정 픽셀 또는 영역이 얼마나 정확한지에 대한 확신(Confidence)을 표현하는 지도(Map), 밝을수록 신뢰도 높음

- 컬러 포인트 클라우드의 다양한 시점에서 본 장면(중간 및 하단)

을 보여준다.

카메라 파라미터는 원시 포인트맵(raw pointmaps)에서 복원되며, 자세한 내용은 본 논문의 섹션 3.3에서 확인할 수 있다.

DUSt3R는 강한 시점(viewpoint) 변화 및 초점(focal) 변화에도 문제없이 동작한다.

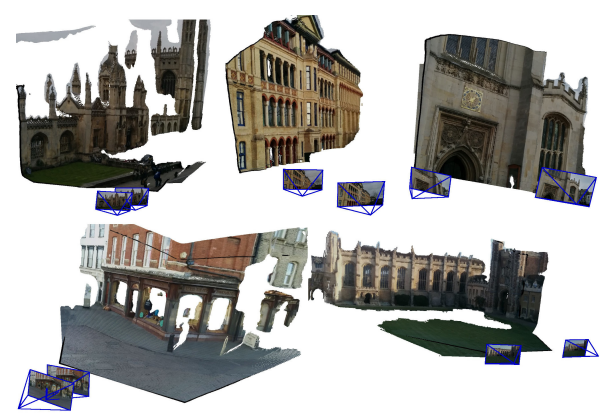

Figure 6. 보이지 않은 장면(즉, KingsCollege(왼쪽 위), OldHospital(가운데 위), StMarysChurch(오른쪽 위), ShopFacade(아래 왼쪽), GreatCourt(아래 오른쪽))을 단 두 장의 이미지로만 3D 재구성한 예시.

이는 네트워크의 가공되지 않은(raw) 출력으로, 컬러 포인트 클라우드를 새로운 시점에서 시각화한 모습을 보여준다.

카메라 파라미터는 원시 포인트맵(raw pointmaps)으로부터 복원되며, 자세한 내용은 본문의 3.3절을 참고.

Figure 7. 두 장의 이미지만으로 이전에 보지 못한 장면(Chess, Fire, Heads, Office – 위쪽 행, Pumpkin, Kitchen, Stairs – 아래쪽 행)을 3D 재구성한 예시.

이는 네트워크의 가공되지 않은(raw) 출력으로, 컬러 포인트 클라우드를 새로운 시점에서 시각화한 결과를 보여준다.

카메라 파라미터는 **원시 포인트맵(raw pointmaps)**에서 복원되며, 자세한 내용은 본문의 3.3절을 참고.

Figure 8. 거의 반대 방향에서 촬영된 이미지들로부터 3D 재구성한 예제들.

각 4가지 사례(오토바이, 토스터, 벤치, 정지 표지판)에 대해:

- 좌측 상단: 두 개의 입력 이미지

- 중앙 상단: 네트워크의 가공되지 않은(raw) 출력, 즉 깊이 맵(depthmaps)

- 우측 상단: 신뢰도 맵(confidence maps)

- 중앙 및 하단: 컬러 포인트 클라우드의 다양한 시점에서 본 결과

카메라 파라미터는 원시 포인트맵(raw pointmaps)에서 복원되며, 자세한 내용은 본문의 3.3절을 참고.

DUSt3R은 거의 겹치는 시각 정보가 없는 경우에도 강한 시점 변화(viewpoint changes)를 문제없이 처리할 수 있음.

예를 들어, 정지 표지판과 오토바이 사례에서는 두 이미지 간에 거의 중복된 시각 정보가 없음에도 성공적인 3D 복원이 가능함.

이 예제들은 임의로 선택된 것(randomly chosen)이며, CO3D v2 데이터셋의 보지 못한(unseen) 시퀀스에서 가져옴.

애니메이션된 시각화는 제공된 비디오를 참고.

Figure 9. 글로벌 정렬 후, RealEstate10K 실내 시퀀스에서 무작위로 추출한 4개의 프레임을 이용한 재구성 예시.

왼쪽에는 4장의 입력 프레임, 오른쪽에는 결과 포인트 클라우드와 복원된 카메라 내부 파라미터(intrinsics) 및 자세(poses)가 시각화되어 있다.

결론 정리

- 사전 카메라 정보 없이도 깊이, 신뢰도, 카메라 자세, 컬러 포인트 클라우드 등을 한 번에 복원

- 적은 수의 이미지(심지어 2장)만으로도 정교한 3D 재구성이 가능

- Transformer 기반으로 강한 일반화 성능을 확보

- 실내외, 극단적 시점 변화 같은 복잡한 환경에서도 강건하게 동작

'컴퓨터비전&AI' 카테고리의 다른 글

| [논문정리] 3. DUSt3R: Geometric 3D Vision Made Easy (0) | 2025.02.27 |

|---|---|

| 논문 읽는 법 with 챗GPT (0) | 2025.02.12 |

| [논문리뷰였던것] Deep learning-guided video compression for machine vision tasks 였지만 VVC 이론. (0) | 2025.02.12 |

| NeRF: Neural Radiance Fields (0) | 2024.12.22 |

| [배울랑교AI] 이미지 처리 (0) | 2024.11.27 |